Der Aufstieg von KI in der Cybersicherheit ist unübersehbar. Große Sprachmodelle (LLMs) wie GPT-4 stehen im Mittelpunkt und finden sich überall wieder, von Code-Assistenten bis hin zu Sicherheitstools. Penetrationstests – traditionell ein langsamer, manueller Prozess – erleben nun eine KI-gesteuerte Revolution. Tatsächlich gaben in einer aktuellen Studie 9 von 10 Sicherheitsexperten an, dass sie glauben, KI werde letztendlich Penetrationstests übernehmen. Das Versprechen ist verlockend: Man stelle sich die Gründlichkeit eines erfahrenen Pentester kombiniert mit der Geschwindigkeit und Skalierbarkeit einer Maschine vor. Hier kommt das Konzept von „Pentest GPT“ ins Spiel, und es verändert unsere Denkweise über offensive Sicherheit.

Doch was ist Pentest GPT eigentlich genau? Und ebenso wichtig: Was ist es nicht? Bevor Sie sich ein glorifiziertes ChatGPT-Skript vorstellen, das Systeme auf magische Weise hackt, lassen Sie uns den Begriff klären und untersuchen, wie LLMs in den Pentesting-Prozess integriert werden. Wir werden auch die Grenzen von GPT-gestützten Pentests beleuchten – von KI-Halluzinationen bis hin zu Kontextlücken – und warum menschliche Expertise weiterhin entscheidend ist. Schließlich werden wir sehen, wie der Ansatz von Aikido Security (unsere kontinuierliche KI-gesteuerte Pentest-Plattform) diese Herausforderungen anders angeht: mit menschlicher Validierung, entwicklerfreundlichen Ausgaben und CI/CD-Integration. Tauchen wir ein in einen ruhigen, pragmatischen Blick auf diese neue Ära des KI-gestützten Penetrationstests.

Was bedeutet „Pentest GPT“ wirklich (und was nicht)?

„Pentest GPT“ bezeichnet die Anwendung von Sprachmodellen im GPT-Stil auf Workflows von Penetrationstests. Vereinfacht ausgedrückt geht es darum, ein KI-Gehirn zu nutzen, um Teile der Arbeit eines Pentester zu emulieren – von der Kartierung von Angriffspfaden bis zur Interpretation von Scan-Ergebnissen. Es ist jedoch nicht so einfach, ChatGPT zu nehmen, ihm einen Hacker-Hoodie überzuziehen und einen vollständigen Penetrationstest von einem einzigen Prompt zu erwarten. Die Unterscheidung ist wichtig.

Allgemeine Modelle wie ChatGPT werden auf breiten Internettexten trainiert und können sicherlich Sicherheitskonzepte erklären oder Angriffe brainstormen, aber ihnen fehlt standardmäßig spezialisiertes Wissen über offensive Sicherheit. Sie wurden nicht mit einem tiefgreifenden Verständnis von Exploit-Frameworks, CVE-Datenbanken oder dem Schritt-für-Schritt-Workflow eines echten Pentester entwickelt. Im Gegensatz dazu ist ein echtes Pentest GPT-System typischerweise für Sicherheit feinabgestimmt. Es wird auf kuratierten Daten wie Schwachstellenbeschreibungen, Red-Team-Playbooks, Exploit-Code und echten Pentest-Berichten trainiert. Diese Spezialisierung bedeutet, dass es die Sprache von Hacking-Tools und -Techniken „spricht“.

Ein weiterer wesentlicher Unterschied ist die Integration. Pentest GPT ist nicht nur ein isolierter Chatbot – es ist normalerweise in tatsächliche Sicherheitstools und Datenquellen integriert. Zum Beispiel könnte ein gut konzipiertes Pentest GPT in Scanner und Frameworks (Nmap, Burp Suite, Metasploit usw.) integriert sein, um deren Ausgabe zu interpretieren und nächste Schritte zu empfehlen. Es dient als intelligente Schicht zwischen Tools und ersetzt diese nicht vollständig. Eine hilfreiche Analogie aus einem Kommentar: ChatGPT könnte Ihnen eine gute Zusammenfassung dessen geben, was SQL-Injection ist, während Pentest GPT Sie durch das Auffinden einer aktiven SQL-Injection auf einer Website führen, eine maßgeschneiderte Payload generieren, den Exploit validieren und sogar eine anschließende Korrektur vorschlagen könnte. Kurz gesagt, Pentest GPT ist mehr als nur „ChatGPT + ein Prompt = Pentest“. Es impliziert einen zweckgebundenen KI-Assistenten, der den Hacking-Kontext versteht und darauf reagieren kann.

Es ist auch wichtig zu beachten, was Pentest GPT nicht ist. Es ist kein magischer Ein-Klick-Hacker, der alle anderen Tools überflüssig macht. Im Hintergrund greift es immer noch auf das übliche Arsenal zurück – Scanner, Skripte und Exploits – nutzt aber das LLM, um alles miteinander zu verbinden. Stellen Sie es sich als Verstärker für die Automatisierung vor: Es fügt den Rohdaten, die traditionelle automatisierte Tools ausgeben, Argumentation und Kontext hinzu. Und trotz des eingängigen Namens ist „PentestGPT“ in der Praxis kein einzelnes Produkt oder KI-Modell, sondern eine wachsende Kategorie von Ansätzen. Frühe Prototypen wie PentestGPT (ein Open-Source-Forschungsprojekt) und AutoPentest-GPT haben mehrstufige Tests unter Anleitung von GPT-4 demonstriert, und etablierte Sicherheitsplattformen (wie Aikido) integrieren nun GPT-gestützte Argumentation in ihre Pentest-Engines. Das Feld entwickelt sich schnell, aber die Kernidee bleibt: LLMs nutzen, um automatisiertes Penetrationstesting intelligenter und menschlicher in seinem Denken zu gestalten.

Wie LLMs (wie GPT-4) in Penetrationstests eingesetzt werden

Moderne Penetrationstests umfassen mehr als nur das Ausführen eines Scanners und das Erstellen eines Berichts. Erfahrene Tester verketten mehrere Schritte – von der Aufklärung über die Ausnutzung bis zur Post-Exploitation – und improvisieren oft basierend auf ihren Erkenntnissen. LLMs erweisen sich als geschickt darin, mehrere dieser Phasen zu unterstützen (oder sogar autonom durchzuführen). Hier sind einige der Schlüsselrollen, die KI-gesteuerte GPT im Pentesting-Prozess spielt:

1. Pfad-Logik: Die Punkte zwischen Schwachstellen verbinden

Eine der mächtigsten Fähigkeiten einer KI wie GPT-4 ist es, Angriffe über mehrere Schritte hinweg zu planen, fast wie ein menschlicher Stratege. Zum Beispiel könnte ein typischer Schwachstellenscanner Ihnen mitteilen: „Server X führt einen veralteten Dienst aus“ und separat: „Benutzerdatenbank hat schwache Standardanmeldeinformationen.“ Es liegt an einem menschlichen Pentester, zu erkennen, dass diese beiden Erkenntnisse kombiniert werden könnten – sich mit Standardanmeldeinformationen in die Datenbank einzuloggen und dann den veralteten Server für tieferen Zugriff auszunutzen. LLMs sind hervorragend in dieser Art von Argumentation. Ein Pentest GPT kann automatisch die Punkte zu einem Angriffspfad verbinden und erkennen, dass eine Kette von Problemen geringerer Schwere, wenn sie zusammen genutzt werden, zu einer schwerwiegenden Kompromittierung führen könnte (z. B. Domänenadministratorrechte oder vollständige Anwendungsübernahme). Diese „Gesamtbild“-Synthese leisten regelbasierte Tools selten, aber ein GPT-Modell kann dies aufgrund seines Kontextverständnisses. In der Praxis bedeutet dies, dass KI-gesteuerte Pentest-Tools Angriffs-Narrative liefern können, nicht nur isolierte Erkenntnisse. Sie erklären, wie eine geringfügige Fehlkonfiguration plus ein geleakter API-Schlüssel zu einer kritischen Sicherheitsverletzung eskaliert werden könnte, was Entwickelnden und Sicherheitsteams einen wesentlich klareren Einblick in Risiken gibt.

2. Angriffssimulation: Erstellen und Ausführen von Exploits

LLMs wie GPT-4 werden auch verwendet, um Angreiferaktionen während eines Pentests zu simulieren. Dies geht über das bloße Aufzeigen einer Schwachstelle hinaus – die KI kann dabei helfen, die Ausnutzungsschritte (auf kontrollierte Weise) auszuführen. Wenn das System beispielsweise eine SQL-Injection in einem Webformular vermutet, kann ein KI-Agent eine maßgeschneiderte Nutzlast für dieses spezifische Formular generieren und versuchen, Daten abzurufen. Wenn es eine Befehlsinjection findet, kann es versuchen, eine Shell zu erstellen oder sensible Informationen zu extrahieren, genau wie ein Mensch. Das Modell kann auf sein Training (das unzählige Exploit-Beispiele umfasst) zurückgreifen, um Eingabezeichenfolgen oder HTTP-Anfragen spontan zu erstellen. Diese Fähigkeit, sich anzupassen und Angriffs-Payloads zu erstellen, erspart viel manuelles Scripting. Im Wesentlichen lässt sie die KI als Exploit-Entwickler und -Operator agieren. Ebenso wichtig ist, dass ein gutes Pentest-GPT die Wirkung des Exploits validiert – beispielsweise indem es bestätigt, dass die SQLi tatsächlich die Datenbank ausgelagert hat oder dass die Befehlsinjektion eine Remote-Code-Ausführung ermöglicht –, anstatt blind seinem ersten Versuch zu vertrauen. Auf der Plattform Aikidobeispielsweise führt ein Agent, sobald er ein potenzielles Problem entdeckt hat, automatisch zusätzliche Überprüfungen und Payloads durch, um zu beweisen, dass der Fund ausnutzbar ist, und um sicherzustellen, dass es sich nicht um einen Fehlalarm handelt. Diese Art der KI-gesteuerten Angriffssimulation bringt automatisierte Tests viel näher an das, was ein kreativer menschlicher Angreifer tun würde: etwas ausprobieren, die Reaktion beobachten, die Taktik anpassen und zum nächsten Schritt übergehen.

3. Verkettung von Schritten: Adaptive mehrstufige Angriffe

Pentesting ist selten eine einmalige Angelegenheit, sondern eine Kette von Aktionen und Reaktionen. LLMs werden eingesetzt, um mehrstufige Angriffsketten auf adaptive Weise zu orchestrieren. Stellen Sie sich folgendes Szenario vor: Ein KI-Agent beginnt mit der Aufklärung, findet einige offene Ports und eine durchgesickerte Anmeldeinformation und nutzt dann GPT-gestützte Logik, um den nächsten Schritt zu entscheiden – vielleicht die Anmeldeinformation zum Einloggen verwenden, dann einen Exploit zur Rechteausweitung auf dem Zielsystem ausführen und so weiter. Im Gegensatz zu herkömmlichen Tools, die einem festen Skript folgen, kann ein LLM-gesteuertes System Entscheidungen spontan treffen. Wenn ein Weg blockiert ist (z. B. wenn die Anmeldung fehlschlägt oder ein Dienst nicht ausgenutzt werden kann), kann es dynamisch den Kurs ändern und einen anderen Weg versuchen, ähnlich wie es ein Mensch tun würde. Forscher beschreiben dies als einen „agentenbasierten” Ansatz: Mehrere KI-Agenten übernehmen verschiedene Aufgaben (Aufklärung, Schwachstellenscan, Ausnutzung usw.) und geben Informationen untereinander weiter, koordiniert durch die Schlussfolgerungen des LLM. Das Ergebnis ist ein automatisierter Pentest, der den Kontext über alle Schritte hinweg beibehält und dabei lernt. Beispielsweise können Ergebnisse aus der Anfangsphase (wie eine Liste von Benutzerrollen oder ein API-Schema) für spätere Angriffe (wie das Testen der rollenbasierten Zugriffskontrolle) herangezogen werden. Das natürliche Sprachverständnis von GPT-4 hilft dabei, indem es unstrukturierte Daten (Dokumente, Fehlermeldungen) interpretiert und dieses Wissen in nachfolgende Exploits einfließen lässt. Diese Fähigkeit zur Verkettung war traditionell nur Menschen vorbehalten. Jetzt können KI-Agenten viele dieser logischen Übergänge bewältigen: Recon → Exploit → Post-Exploit → Cleanup, wobei sie mehrere Techniken verketten, um ein Ziel zu erreichen. Das ist natürlich nicht narrensicher – komplexe Geschäftslogik oder neuartige Angriffspfade können eine KI immer noch aus der Bahn werfen –, aber es ist ein großer Sprung in der Leistungsfähigkeit. Auf diese Weise funktioniert insbesondere der KI-Pentest Aikido: Dutzende oder Hunderte von Agenten schwärmen parallel zum Ziel aus, wobei sich jeder auf unterschiedliche Blickwinkel konzentriert, und das System nutzt ein LLM-gesteuertes Gehirn, um ihren Fortschritt durch eine Kill-Chain (Entdeckung, Ausnutzung, Privilegienerweiterung usw.) zu koordinieren. Das Ergebnis ist eine weitaus gründlichere Übung, bei der die KI die Ergebnisse Schritt für Schritt eskalieren kann, anstatt bei einer langen Liste separater Probleme stehen zu bleiben.

Grenzen von GPT-gestütztem Pentesting: Halluzinationen, Kontextlücken und der Faktor Mensch

Angesichts der Begeisterung rund um KI-Penetrationstests ist es wichtig, sich mit den Grenzen dieser Technologie auseinanderzusetzen und zu verstehen, warum Menschen noch nicht aus dem Spiel sind. LLMs sind leistungsstark, haben jedoch gut dokumentierte Schwächen, die im Sicherheitskontext eine Rolle spielen. Hier sind einige wichtige Einschränkungen von „GPT-basierten” Penetrationstests und Gründe, warum erfahrene menschliche Experten nach wie vor eine entscheidende Rolle spielen:

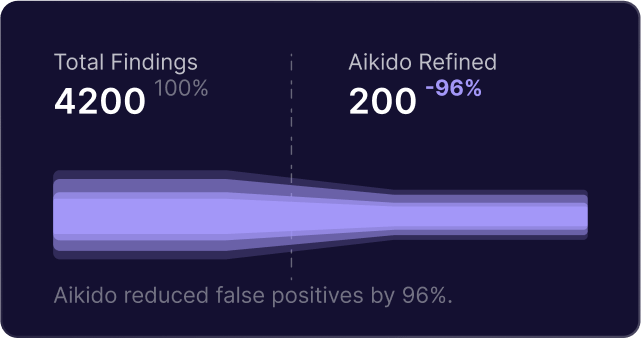

- Halluzinationen und Fehlalarme: GPT-Modelle liefern manchmal Informationen, die plausibel erscheinen, aber falsch sind – ein Phänomen, das als Halluzination bezeichnet wird. Bei Penetrationstests könnte dies bedeuten, dass eine KI fälschlicherweise eine Schwachstelle meldet, die gar nicht vorhanden ist, oder harmloses Verhalten als bösartig interpretiert. Beispielsweise könnte ein GPT auf der Grundlage von Mustern, die es gesehen hat, ein fiktives „CVE-2025-9999“ erfinden oder fälschlicherweise zu dem Schluss kommen, dass ein System anfällig ist, weil es eine bestimmte Reaktion erwartet. Diese falsch positiven Ergebnisse können Zeit verschwenden und das Vertrauen in das Tool untergraben. Um dem entgegenzuwirken, ist eine strenge Validierung erforderlich. (Im System Aikidobeispielsweise wird kein Befund gemeldet, bevor er nicht durch einen echten Exploit oder Check validiert wurde – die Plattform führt den Angriff oder Test automatisch erneut durch, um sicherzustellen, dass das Problem reproduzierbar ist.) Diese Art von Sicherheitsvorkehrung ist unerlässlich, da ein LLM, wenn es nicht überprüft wird, sich selbst davon überzeugen könnte, Geister zu finden.

- Fehlender tiefer Kontext oder aktuelles Wissen: Das Wissen eines LLM ist durch seine Trainingsdaten begrenzt. Wenn das Modell nicht kürzlich aktualisiert wurde, könnten ihm neu bekannt gewordene Schwachstellen oder Techniken entgehen – beispielsweise wäre ein im letzten Monat veröffentlichter Exploit einem Modell, das im letzten Jahr trainiert wurde, nicht bekannt. Darüber hinaus kennen GPTs den Kontext Ihrer spezifischen Anwendung nicht von Natur aus. Ihnen fehlt die Intuition oder Vertrautheit, die ein menschlicher Tester entwickeln könnte, nachdem er eine App tagelang manuell untersucht hat. Wenn nicht genügend Kontext (wie Quellcode, Dokumentation oder Authentifizierungsdaten) zur Verfügung gestellt wird, könnte ein KI-Agent subtile Logikfehler übersehen oder die Bedeutung bestimmter Ergebnisse falsch einschätzen. Im Wesentlichen verfügt GPT über ein breites Spektrum an Sicherheitswissen, aber nicht über eine angeborene Tiefe in Bezug auf Ihre Umgebung. Die Bereitstellung von mehr Kontext für die KI (z. B. durch die Verknüpfung von Repository-Code oder Beschreibungen des Benutzerflusses) kann dies abmildern, aber es besteht immer noch eine Lücke zwischen dem Wissen um viele allgemeine Informationen und dem tatsächlichen Verständnis eines maßgeschneiderten Zielsystems. Dies ist ein Grund, warum menschliches Urteilsvermögen nach wie vor entscheidend ist – ein erfahrener Tester kann Unregelmäßigkeiten oder übergeordnete Probleme in der Geschäftslogik erkennen, die eine KI, die nicht auf das Geschäft abgestimmt ist, möglicherweise nicht erfasst. (Interessanterweise hat die KI Aikido, wenn sie Code und Kontext erhält, sogar komplexe logische Schwachstellen wie mehrstufige Workflow-Umgehungen aufgedeckt, die menschlichen Testern entgangen sind. Der Kontext ist sowohl für KI als auch für Menschen entscheidend.)

- Übermäßiges Vertrauen in Muster: Herkömmliche Pentest-KIs stützen sich möglicherweise auf bekannte Angriffsmuster und Playbooks. Wenn etwas außerhalb dieser Muster liegt, könnte die KI Schwierigkeiten haben. Beispielsweise könnte ein neuartiger Sicherheitsmechanismus oder eine ungewöhnliche kryptografische Implementierung das Modell verwirren, während ein Mensch dies kreativ untersuchen würde. GPT-4 kann zwar durchaus verallgemeinern und sogar kreativ sein, aber letztendlich folgt es den statistischen Mustern aus seinem Training. Das bedeutet, dass es schwieriger für es ist, Edge-Case-Schwachstellen oder sehr anwendungsspezifische Fehler (z. B. den Missbrauch einer Anwendungsfunktion, über den noch niemand öffentlich geschrieben hat) zu finden. Menschen mit ihrer Intuition und ihrer Fähigkeit, mit Unklarheiten umzugehen, sind nach wie vor besser darin, solche seltsamen, einmaligen Probleme aufzudecken.

- Ethische und Umfangsbeschränkungen: Eine praktische Überlegung – GPT-Modelle kennen von Natur aus nicht die ethischen Grenzen oder Umfangsbeschränkungen eines Pentests, sofern sie nicht ausdrücklich kontrolliert werden. Ein menschlicher Pentester ist sich bewusst, dass er die Produktion nicht stören und Datenzerstörung vermeiden muss usw. Ein autonomer Agent benötigt möglicherweise strenge Leitplanken (und tatsächlich bieten gute Plattformen Safe-Mode-Einstellungen und Umfangsdefinitionen, um KI-Agenten zielgerichtet und nicht destruktiv zu halten). Dies ist zwar eher ein Problem des Plattformdesigns als ein Mangel von GPT selbst, unterstreicht jedoch, dass menschliche Aufsicht erforderlich ist, um sicherzustellen, dass die KI sicher und innerhalb der vereinbarten Einsatzregeln arbeitet.

- Die Notwendigkeit menschlicher Interpretation und Anleitung: Selbst wenn die KI alles richtig macht, braucht man oft einen Menschen, der die Ergebnisse für strategische Entscheidungen interpretiert. Zum Beispiel kann es menschliches Eingreifen erfordern, um zu entscheiden, welche Schwachstellen für das Unternehmen wirklich wichtig sind, oder um zu überlegen, wie ein Angreifer eine Entdeckung über das automatisch Ermittelte hinaus ausnutzen könnte. Hinzu kommt der Aspekt des Vertrauens – viele Unternehmen möchten, dass ein human security einen von der KI erstellten Pentest-Bericht überprüft, um ihn zu kontrollieren und bei Bedarf in geschäftliche Begriffe zu übersetzen. KI kann eine Vielzahl von Daten generieren; menschliches Fachwissen ist erforderlich, um Prioritäten zu setzen und Abhilfemaßnahmen in einem breiteren Sicherheitsprogrammkontext zu planen.

Zusammenfassend lässt sich sagen, dass GPT-gestützte Penetrationstests eher eine Verstärkung als ein Ersatz für den Menschen sind. Sie können die Routineaufgaben bei Angriffen übernehmen, einen größeren Bereich abdecken und dies kontinuierlich tun. Aber es sind immer noch Menschen , die die Ziele festlegen, neue Fälle bearbeiten und kritische Entscheidungen über Risiken treffen. Wie eine Beobachtung zeigt, werden die besten Ergebnisse erzielt, wenn GPT mit deterministischen Tools und menschlicher Aufsicht kombiniert wird – die KI übernimmt das Denken und Berichten, während Tools und Menschen für eine zuverlässige Validierung sorgen. Die meisten Teams, die KI-Penetrationstests einsetzen, KI-Penetrationstests diese als Grundlage und fügen dann für den letzten Schritt eine menschliche Überprüfung hinzu. Auf diese Weise profitieren Sie von der Effizienz der KI und der Weisheit menschlicher Experten, die Hand in Hand arbeiten.

Der Ansatz Aikido: Kontinuierliche KI-Penetrationstests menschlicher Note

Bei Aikido haben wir KI in Pentests über unsere Plattform (namens Aikido ) integriert, dabei jedoch die oben genannten Einschränkungen sorgfältig berücksichtigt. Das Ziel besteht darin, LLMs für das einzusetzen, was sie am besten können – Geschwindigkeit, Skalierbarkeit und Schlussfolgerungen –, während ihre Schwächen gemildert werden. Hier erfahren Sie, wie sich die KI-gesteuerten Penetrationstests Aikidovon einem einfachen „Pentest GPT”-Skript oder herkömmlichen automatisierten Tools unterscheiden:

- Kontinuierliche Tests auf Abruf (CI/CD-Integration): Aikido Sie Penetrationstests durchführen, wann immer Sie möchten – sogar bei jeder Codeänderung. Anstelle eines jährlichen Big-Bang-Pentests können Sie KI-gesteuerte Sicherheitstests in Ihre CI/CD-Pipeline oder Staging-Bereitstellungen integrieren. Das bedeutet, dass neue Funktionen oder Fehlerbehebungen sofort getestet werden und Sicherheit zu einem kontinuierlichen Prozess wird, anstatt ein einmaliges Ereignis zu sein. Unsere Plattform ist auf die Arbeitsabläufe von Entwicklern zugeschnitten, sodass Sie einen Penetrationstest bei einer Pull-Anforderung auslösen oder nächtliche Durchläufe planen können. Wenn Ihre App in die Produktion geht, hat sie bereits eine Reihe von KI-gestützten Tests durchlaufen. Dieser kontinuierliche Ansatz behebt die Geschwindigkeitslücke, die entsteht, wenn sich der Code oft täglich ändert, manuelle Penetrationstests jedoch nur selten durchgeführt werden. Mit KI-Agenten hält das Testen mit der Entwicklung Schritt.

- Validierte, störungsfreie Ergebnisse: Wir sind uns bewusst, dass die Ergebnisse einer KI überprüft werden müssen. Die Pentest-Engine Aikidoverfügt über eine integrierte Validierung in jedem Schritt. Wenn die KI eine Schwachstelle vermutet, meldet sie diese nicht sofort, sondern startet einen sekundären Validierungsagenten, um den Exploit auf saubere Weise zu reproduzieren und die Auswirkungen zu bestätigen. Nur nachgewiesene, ausnutzbare Probleme schaffen es in den Abschlussbericht. Durch dieses Design erhalten Sie praktisch keine Fehlalarme (wenn ein Problem nicht bestätigt ist, wird es nicht gemeldet) und unser System schützt aktiv vor KI-Halluzinationen über Schwachstellen. Das Ergebnis ist, dass Entwickler nicht mit Warnmeldungen zu „möglichen Problemen“ oder spekulativen Ergebnissen bombardiert werden – sie sehen tatsächlich bestätigte Sicherheitslücken mit Beweisen. Dieser Ansatz verbindet die Kreativität von GPT mit der Vorsicht eines menschlichen Testers: Jedes Ergebnis wird im Wesentlichen doppelt überprüft, sodass Sie den Ergebnissen vertrauen können.

- Volle Transparenz und Entwickelnde Ausgabe: Der KI-Pentest Aikidofunktioniert nicht wie eine Black Box. Wir bieten Ihnen vollständige Transparenz darüber, was die KI-Agenten tun – jede Anfrage, jede Nutzlast und jeder Angriffsversuch kann live in unserem Dashboard beobachtet werden. Dies ist entscheidend für das Vertrauen und das Lernen der Entwickler. Sie können sehen, warum eine Schwachstelle gemeldet wurde und wie sie ausgenutzt wurde, bis hin zu Anfrage-/Antwort-Traces und sogar Screenshots des laufenden Angriffs. Die Endergebnisse werden in einem auditfähigen Bericht zusammengefasst, der alle technischen Details (betroffene Endpunkte, Reproduktionsschritte, Zeitstempel) sowie Risikobeschreibungen in einfacher Sprache und Anleitungen zur Behebung enthält. Wir möchten die Ergebnisse entwicklerfreundlich gestalten: Anstelle einer vagen Angabe wie „Sicherheitslücke in Modul X“ erhalten Sie eine klare Erklärung des Problems, wie es reproduziert werden kann und wie es behoben werden kann. Wir gehen sogar noch einen Schritt weiter – unsere Plattform umfasst eine AutoFix, die bestimmte Ergebnisse (wie eine erkannte SQL-Injection oder Befehlsinjection) automatisch in einen Git-Pull-Request mit den vorgeschlagenen Codeänderungen zur Behebung des Problems umwandelt. Entwickler können diese KI-generierte Korrektur überprüfen, zusammenführen und dann Aikido die Anwendung sofort Aikido lassen, um zu überprüfen, ob die Schwachstelle behoben ist. Dieser enge Kreislauf aus Finden→Beheben→Erneut testen bedeutet eine schnellere Behebung und weniger Hin und Her. All dies geschieht auf eine Weise, die für Entwickler leicht verständlich ist, ohne Sicherheitsjargon oder endlose Rohdatenausgaben des Scanners. Es geht darum, die Pentest-Ergebnisse umsetzbar zu machen.

- Menschliches Fachwissen im Loop: Obwohl unsere Pentesting-Agenten autonom arbeiten, haben wir das menschliche Element nicht entfernt, sondern ergänzt. Zunächst wurde das System selbst mit Hilfe von erfahrenen Penetrationstestern trainiert und optimiert, wobei deren Arbeitsabläufe und Kenntnisse kodiert wurden. Darüber hinaus fördern und unterstützen wir jedoch die menschliche Validierung, wo dies wichtig ist. Viele Aikido nutzen die KI-Ergebnisse als Grundlage und lassen dann ihr Sicherheitsteam oder einen Aikido eine schnelle Überprüfung durchführen, insbesondere bei kritischen Anwendungen. Unsere Erfahrung hat gezeigt, dass die KI die überwiegende Mehrheit der technischen Probleme (und sogar viele knifflige Logikfehler) selbstständig erkennt. Dennoch wissen wir, dass es bei der Sicherheit letztendlich um eine tiefgreifende Verteidigung geht – daher kann eine menschliche Überprüfung zusätzliche Sicherheit bieten, und wir erleichtern die Zusammenarbeit rund um die Ergebnisse der KI. Wenn die KI-Analyse keine kritischen Probleme findet (was natürlich eine gute Nachricht ist), können Unternehmen dank unserer Richtlinie „Keine Ergebnisse = keine Kosten“ für bestimmte Aufträge beruhigt sein. Diese Garantie spiegelt unser Vertrauen in die Gründlichkeit der KI wider, stellt aber auch sicher, dass Sie nicht für einen unvollständigen Test bezahlen müssen, wenn ein Mensch später etwas findet, das die KI übersehen hat. Kurz gesagt: Der Ansatz Aikidokombiniert KI-Automatisierung mit menschlichen Überwachungsoptionen, um das Beste aus beiden Welten zu bieten.

- Sicherheit und Umfangskontrolle: Aikido wurde unter Berücksichtigung der Anforderungen von Unternehmen entwickelt, daher haben wir robuste Kontrollen hinzugefügt, um die KI auf Kurs zu halten. Bevor ein KI-Pentest durchgeführt wird, legen Sie den genauen Umfang fest: welche Domains oder IPs als Ziele zulässig sind, welche tabu sind (aber möglicherweise im Lesemodus aufgerufen werden können), Authentifizierungsdetails und sogar Zeitfenster für die Tests. Die Plattform setzt diese Vorgaben mit einem integrierten Proxy und „Pre-Flight“-Prüfungen durch – wenn etwas falsch konfiguriert oder außerhalb des Umfangs ist, wird der Test nicht fortgesetzt, wodurch Unfälle verhindert werden. Es gibt auch einen „Panikknopf”, mit dem der Test bei Bedarf sofort gestoppt werden kann. Diese Maßnahmen stellen sicher, dass ein autonomer Test niemals außer Kontrolle gerät und nur sichere, vereinbarte Aktionen durchführt, ähnlich wie es ein sorgfältiger menschlicher Pentester tun würde. Weitere Informationen darüber, wie wir Ihre Umgebung schützen, finden Sie unter AikidoSicherheitsarchitektur.

Insgesamt erfüllt die KI-gesteuerte Pentest-Lösung Aikidodie Versprechen von Pentest GPT und behebt gleichzeitig dessen Schwachstellen. Sie erhalten kontinuierliche, intelligente Pentests, die wie ein Mensch reagieren und Angriffe durchdenken können, ohne die typischen Wartezeiten oder Kosten manueller Tests. Gleichzeitig vermeiden Sie die üblichen Störfaktoren der Automatisierung – jede Erkenntnis ist real und wird im Kontext präsentiert. Und Sie haben weiterhin die Möglichkeit (die wir auch empfehlen), Sicherheitsingenieure zur abschließenden Validierung oder zur Bearbeitung von Sonderfällen hinzuzuziehen, um sicherzustellen, dass nichts übersehen wird. Es handelt sich um eine ausgewogene, pragmatische Anwendung von KI: Nutzen Sie die Maschine für das, was sie am besten kann (Geschwindigkeit, Skalierbarkeit, Mustererkennung), und lassen Sie Menschen das tun, was sie am besten können (kreatives Denken und Gesamturteil). Das Endergebnis ist ein Pentest-Prozess, der schneller und häufiger ist, aber auch gründlich und zuverlässig.

Vom Hype zur Realität: Probieren Sie selbst KI-gestütztes Pentesting aus

Entdecken Sie externe Ressourcen und Tools, auf die in diesem Ansatz Bezug genommen wird:

- Nmap – Open-Source-Netzwerk-Mapper, der zur Erkundung verwendet wird.

- Burp Suite – Web-Schwachstellenscanner und Proxy, der in vielen KI-gesteuerten Penetrationstests verwendet wird.

- Metasploit – Penetrationstest-Framework für die Entwicklung und Ausführung von Exploits.

- CVE-Datenbank (NVD) – Die Nationale Schwachstellen-Datenbank zur Verfolgung von Sicherheitslücken.

- PentestGPT GitHub – Open-Source Pentest GPT Forschungsprojekt.

- AutoPentest-GPT Projekt – Framework für automatisiertes Penetrationstesting, basierend auf GPT-Technologie.

Um zu erfahren, wie Sie kontinuierliches und intelligentes Penetrationstesting in Ihr Unternehmen integrieren können, starten Sie in 5 Minuten mit Aikido oder lesen Sie Kundenerfolgsgeschichten über Unternehmen, die bereits Risiken mit KI reduzieren.

Für weitere Bildungsinhalte zu sicherer Entwicklung, DevSecOps und KI in der Sicherheit, besuchen Sie den Aikido Blog.

KI wird menschliche Sicherheitsexperten nicht ersetzen – aber sie wird ihre Arbeit effizienter gestalten und Unternehmen dabei helfen, Software in einem Tempo abzusichern, das der modernen Entwicklung entspricht. LLMs beweisen, dass sie einen Großteil der mühsamen Arbeit des Penetrationstestings übernehmen können, vom Durchsuchen einer Anwendung nach Schwachstellen bis zum Schreiben von Exploits und dem Erstellen von Berichten. Wie wir bereits besprochen haben, bezeichnet der Begriff Pentest GPT diese neue Generation von Tools, die KI-Logik mit Hacking-Know-how verbinden. Das ist nicht nur Hype; es verändert bereits die Art und Weise, wie Pentests durchgeführt werden, und verwandelt eine einmal jährliche Prozedur in eine kontinuierliche, entwicklerfreundliche Praxis.

Wenn Sie neugierig sind, dies in Aktion zu sehen, warum probieren Sie nicht den AI Pentest von Aikido aus? Wir bieten Ihnen die Möglichkeit, einen kostenlosen Self-Service-Pentest für Ihre eigene Anwendung durchzuführen, um zu erleben, wie autonome Agenten Hand in Hand mit Ihrem Entwicklungszyklus arbeiten. Innerhalb weniger Minuten können Sie einen Test konfigurieren und beobachten, wie KI-Agenten Ihre Anwendung systematisch untersuchen – mit voller Transparenz und Kontrolle. Sie erhalten einen detaillierten Bericht innerhalb von Stunden (nicht Wochen), und Sie können ihn sogar in Ihre CI-Pipeline integrieren, sodass jede neue Version automatisch getestet wird. Es ist eine Gelegenheit zu erleben, wie Pentest GPT-Konzepte – Pfad-Reasoning, intelligente Exploitation, Ergebnisvalidierung – in einem realen Produkt zusammenkommen.

Profi-Tipp: Sie können einen KI-gesteuerten Pentest auf Aikido kostenlos starten (Ohne Kreditkarte) oder [auf unserer Website mehr erfahren], wie es funktioniert. Wir sind zuversichtlich, dass Sie, sobald Sie sehen, wie die KI Schwachstellen mit Maschinengeschwindigkeit findet und behebt, zustimmen werden, dass dies ein ruhigerer, intelligenterer Weg ist, Ihre Software sicher zu halten.

Zusammenfassend lässt sich sagen: KI ist in der Cybersicherheit nicht mehr wegzudenken. Der Schlüssel liegt in ihrem klugen Einsatz. Pentest GPT als Konzept zielt darauf ab, menschliche Expertise mit den unglaublichen Fähigkeiten der KI zu erweitern – nicht diese Expertise zu ersetzen. Die Mission von Aikido ist es, kontinuierliche KI-gesteuerte Pentests mit menschlicher Validierung anzubieten, damit Sie Probleme frühzeitig, häufig und mit Zuversicht erkennen können. Während sich die Branche weiterentwickelt, werden diejenigen, die die Effizienz der KI mit dem Einfallsreichtum menschlicher Intelligenz verbinden, am besten positioniert sein, um ihre Systeme gegen die sich ständig ändernde Bedrohungslandschaft zu sichern. Die Zukunft des Penetrationstestings wird jetzt geschrieben – und sie wird teilweise von GPT-4 geschrieben.

(Möchten Sie den nächsten Schritt wagen? Sie können in 5 Minuten mit einem KI-Pentest starten auf der Aikido-Plattform oder eine Demo vereinbaren, um zu sehen, wie es in Ihren DevSecOps-Workflow passt. Sicherheitstests müssen nicht langsam oder isoliert sein – mit den richtigen KI-Tools werden sie zu einem kontinuierlichen Bestandteil der Entwicklung, der Ihr Team befähigt, Software mit ruhigem Gewissen zu entwickeln und bereitzustellen.)

Sichern Sie Ihre Software jetzt.