Der International AI Safety Report 2026ist einer der bislang umfassendsten Überblicke über die Risiken, die von universellen KI-Systemen ausgehen. Er wurde von über 100 unabhängigen Experten aus mehr als 30 Ländern erstellt und zeigt, dass KI-Systeme zwar Leistungen erbringen, die noch vor wenigen Jahren wie Science-Fiction erschienen, die Risiken von Missbrauch, Fehlfunktionen sowie systematischen und grenzüberschreitenden Schäden jedoch offensichtlich sind.

Der Bericht liefert überzeugende Argumente für eine bessere Bewertung, Transparenz und Schutzmaßnahmen. Eine direkte Frage bleibt jedoch noch ungeklärt: Was bedeutet „sicher“, wenn KI autonom gegen reale Systeme arbeitet?

Eine Zusammenfassung der interessanten Erkenntnisse aus dem Internationalen Bericht zur Sicherheit künstlicher Intelligenz umfasst:

- Mindestens 700 Millionen Menschen nutzen wöchentlich KI-Systeme, wobei die Akzeptanzrate höher ist als bei Personalcomputern in ihren Anfangsjahren.

- Mehrere KI-Unternehmen haben ihre Modelle für 2025 mit zusätzlichen Sicherheitsmaßnahmen veröffentlicht, nachdem Tests vor der Einführung nicht ausschließen konnten, dass die Systeme Nicht-Experten bei der Entwicklung biologischer Waffen helfen könnten. (!!!) (Unklar ist, ob die zusätzlichen Sicherheitsmaßnahmen dies weiterhin vollständig verhindern würden.)

- Sicherheitsteams haben dokumentiert, dass KI-Tools sowohl von unabhängigen Akteuren als auch von staatlich geförderten Gruppen bei tatsächlichen Cyberangriffen eingesetzt werden.

Der Bericht befasst sich ausführlich mit den Ansätzen zum Umgang mit vielen der mit KI verbundenen Risiken – hier ist unsere Meinung dazu:

Wo Aikido mit dem Bericht Aikido (und Möglichkeiten, wie es noch weiter gehen könnte)

1. Mehrschichtige Verteidigung ist wichtig

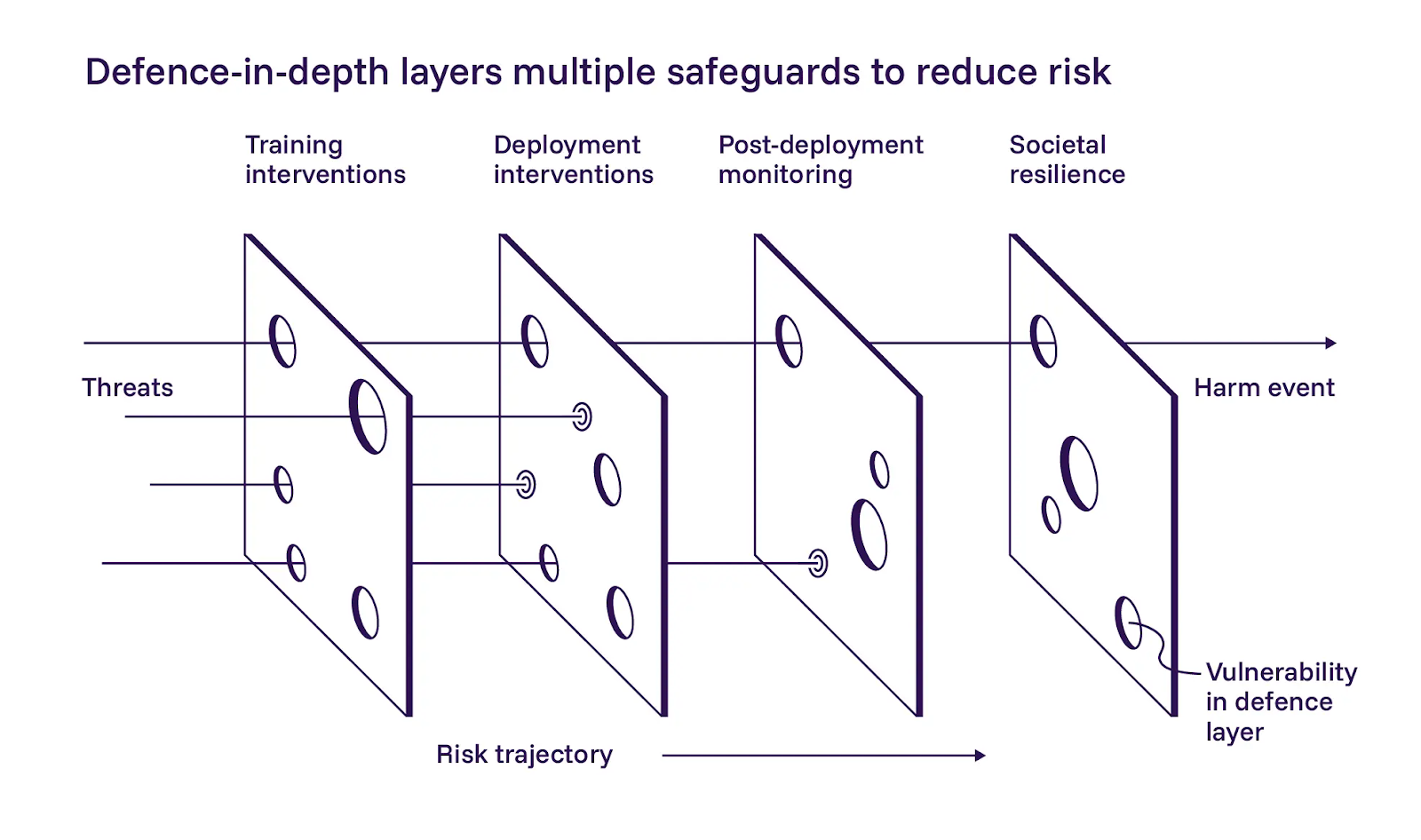

Der Bericht skizziert einen mehrschichtigen Ansatz für die Sicherheit von KI, der in drei Ebenen unterteilt ist: Entwicklung sicherer Modelle während des Trainings, Hinzufügen von Kontrollen bei der Bereitstellung und Überwachung der Systeme nach ihrer Inbetriebnahme. Wir stimmen der Anwendung dieser Ebenen weitgehend zu.

Der Bericht betont die erste Ebene, die sicherere Modellentwicklung. Die Autoren sind vorsichtig optimistisch, dass trainingsbasierte Abhilfemaßnahmen helfen können, räumen jedoch auch ein, dass diese nur schwer in großem Maßstab umzusetzen sind. Wir stimmen zwar zu, dass KI-Betreiber während des Trainings ihr Bestes geben sollten, doch weicht unsere Philosophie in diesem Fall leicht von der des Berichts ab. Wir können uns nicht auf Aufforderungen oder Anweisungen verlassen, um agentenbasierte Systeme im Rahmen zu halten. Eine mehrschichtige Verteidigung funktioniert nur, wenn jede Schicht unabhängig voneinander ausfallen kann.

2. Validierung als Sicherheitsanforderung

Der Bericht geht nur am Rande auf die Details der Umsetzung der zweiten Ebene, also der Kontrollen während der Bereitstellung, ein, aber wir glauben, dass hier die schnellsten Fortschritte erzielt werden können.

Der internationale Bericht dokumentiert Modelle, die ihre Bewertungen auf bedenkliche Weise manipulieren. Einige finden Abkürzungen, mit denen sie bei Tests gut abschneiden, ohne das zugrunde liegende Problem tatsächlich zu lösen (Reward Hacking). Andere erzielen absichtlich schlechtere Leistungen, wenn sie merken, dass sie bewertet werden, um Einschränkungen zu vermeiden, die hohe Punktzahlen nach sich ziehen könnten (Sandbagging). In beiden Fällen optimieren die Modelle etwas anderes als das beabsichtigte Ziel.

Wir kamen zu dem gleichen Schluss: Sobald KI-Systeme autonom arbeiten, kann man ihren Selbstauskünften, ihrem Konfidenzniveau oder ihren Argumentationsketten nicht mehr trauen. Ein Agent, der seine eigenen Entdeckungen validiert, schafft einen Single Point of Failure, der als Redundanz getarnt ist. Für einen sicheren Betrieb müssen erste Ergebnisse als Hypothesen behandelt, das Verhalten vor der Berichterstattung reproduziert und eine von der Entdeckung getrennte Validierungslogik verwendet werden. Diese Validierung kann sogar von einem anderen KI-Agenten stammen.

3. Reduzieren Sie Risiken, bevor Sie Agenten in Live-Umgebungen ausführen lassen.

Die dritte Ebene des Berichts befasst sich mit der Beobachtbarkeit, Notfallkontrollen und kontinuierliche Überwachung der Inbetriebnahme der Systeme. Dies deckt sich mit unseren Erfahrungen aus der Praxis.

Der Black-Box-Betrieb ist für autonome Systeme, die mit der Produktionsinfrastruktur interagieren, nicht akzeptabel. Daher betrachten wir Not-Aus-Mechanismen als unverzichtbare Anforderungen. Wenn Sie nicht sehen können, was ein Agent tut, oder ihn nicht stoppen können, wenn er aus der Bahn gerät, betreiben Sie ihn nicht sicher, unabhängig davon, wie gut das zugrunde liegende Modell ist.

4. Eine schnelle Injektion erfordert strenge Auflagen, keine Hoffnung

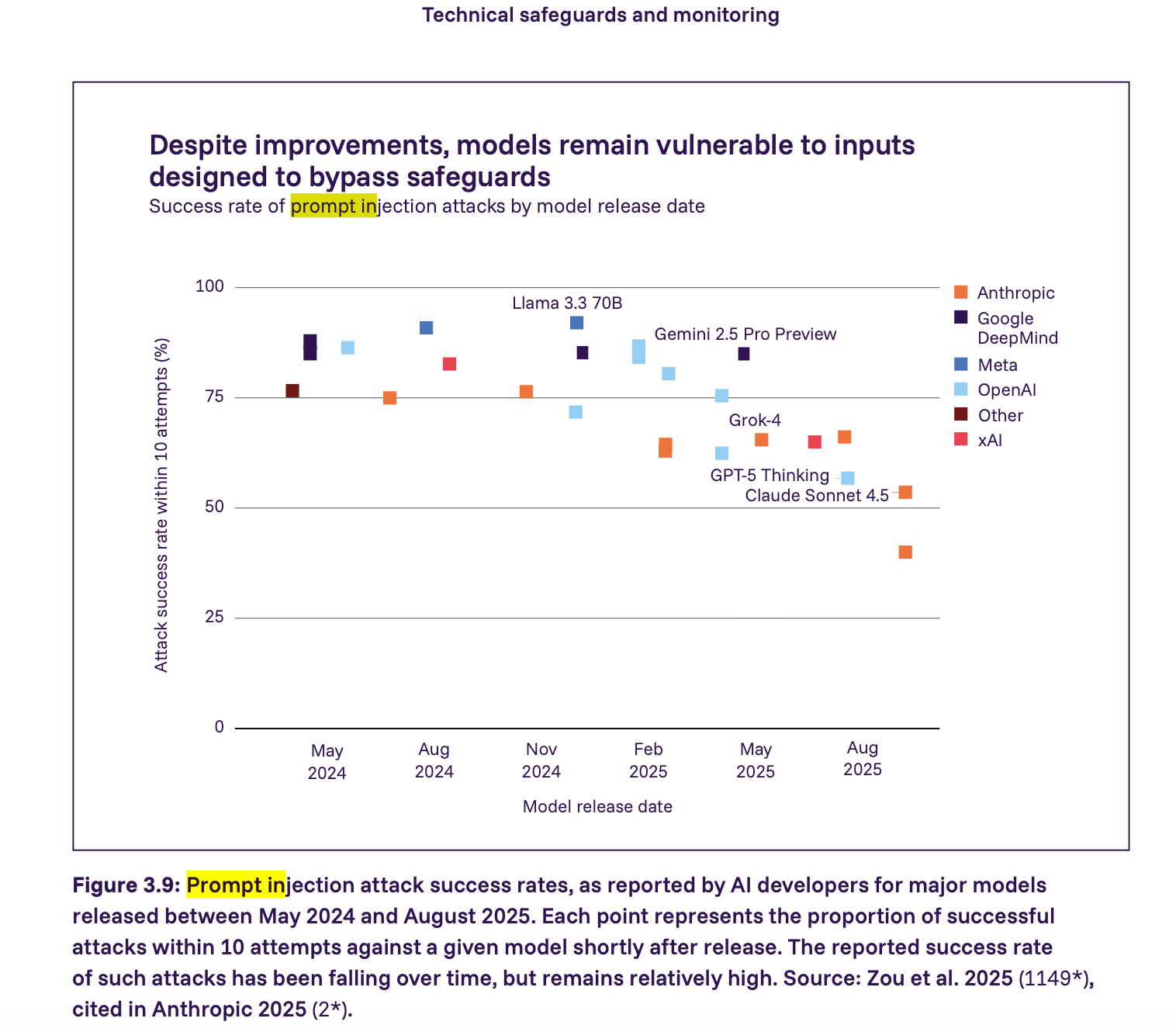

Der Bericht zeigt, dass Prompt-Injection-Angriffe nach wie vor eine ernsthafte Schwachstelle darstellen – viele wichtige Modelle im Jahr 2025 könnten mit relativ wenigen Versuchen erfolgreich durch Prompt-Injection angegriffen werden. Die Erfolgsquote sinkt zwar, bleibt aber relativ hoch. Wir gehen noch einen Schritt weiter als der Bericht und behaupten, dass jeder Agent, der mit nicht vertrauenswürdigen Anwendungsinhalten interagiert, standardmäßig als anfällig für Prompt-Injection angesehen werden muss. Sicherheit entsteht in diesem Zusammenhang durch die Durchsetzung von Einschränkungen und nicht durch das Hoffen, dass sich Modelle korrekt verhalten.

Was unserer Meinung nach als Nächstes kommen sollte

Systeme, nicht nur Modelle

Der Bericht spricht sich nachdrücklich für eine umfassende Verteidigung, Transparenz und Bewertung aus. Diese Aspekte sind zwar wichtig, doch viele der dringendsten Probleme treten erst auf, wenn Modelle mit Tools, Anmeldedaten und Live-Umgebungen verbunden werden. Aus diesem Grund sind Anforderungen auf Implementierungsebene so wichtig (und notwendig). Wir müssen diese Grundsätze in konkrete technische Anforderungen umsetzen, die von den Teams umgesetzt werden können.

Basierend auf dem Betrieb von KI-Penetrationstests in der Produktion sind wir der Meinung, dass die Mindestanforderungen an die Sicherheit autonomer KI-Systeme Folgendes umfassen sollten:

- Missbrauchsprävention Eigentumsüberprüfung

- Erzwungene Bereichskontrolle auf Netzwerkebene

- Trennung zwischen Denken und Handeln

- Vollständige Beobachtbarkeit und Notfallkontrollen

- Garantien hinsichtlich Datenaufbewahrung und -verarbeitung

- Sofortige Eindämmung der Injektion

- Validierung und Falsch-positiv-Kontrolle

Wir haben festgestellt, dass dies die Mindestanforderungen für die Sicherheit sind. Wenn Sie eine davon außer Acht lassen, gehen Sie ein inakzeptables Risiko ein. Wir gehen in unserem Blogbeitrag über KI-Penetrationstests näher auf diese Anforderungen ein.

Sicherheitsgrundlagen als Bausteine der Politik

Der Internationale Bericht zur Sicherheit künstlicher Intelligenz stellt einen bedeutenden Fortschritt auf dem Weg zu einem gemeinsamen Verständnis der Risiken künstlicher Intelligenz zwischen Regierungen, Forschern und Industrie dar. Die Herausforderung besteht nun darin, Forschungsergebnisse, regulatorische Rahmenbedingungen und praktische Anwendungsbeispiele miteinander zu verbinden.

Der Bericht bringt zwar einige wirklich risikoreiche Szenarien und beunruhigende Statistiken darüber auf den Tisch, wie schnell sich die Fähigkeiten weiterentwickeln. Das ist jedoch kein Grund, in Panik zu geraten oder „KI” als einen beängstigenden Monolithen zu regulieren. Der Bericht selbst stellt fest, dass die Sicherheitsvorkehrungen der Entwickler sehr unterschiedlich sind und

dass normative Vorschriften defensive Innovationen behindern können. Wir stimmen dem zu. Vorschriften sollten es vermeiden, einen einzigen Implementierungsweg vorzuschreiben. Stattdessen sollten politische Maßnahmen klare, ergebnisorientierte Sicherheitsgrundlagen definieren, die als Bausteine für umfassendere Rahmenwerke dienen können.

Im Rahmen der Bemühungen um die Schaffung ergebnisorientierterer Sicherheitsrahmenwerke haben wir unser Dokument zu den Mindestsicherheitsanforderungen für KI-gesteuerte Sicherheitstests veröffentlicht. Für Teams, die KI-Penetrationstests evaluieren oder autonome Sicherheitssysteme entwickeln, dient dieser Leitfaden als herstellerneutrale Referenz. Wir hoffen, dass dies Teams dabei hilft, KI-Penetrationstests zu evaluieren, sicherere autonome Sicherheitssysteme zu entwickeln und zur Festlegung klarer Grundlinien beizutragen, die sowohl für Entwickler als auch für Regulierungsbehörden funktionieren.